【3DEqualizer教程】3DEqualizer4 R5新功能详解 【视频演示】

› 社区话题 › 📽️PFtrack,3DEqualizer,Mocha追踪 › 【3DEqualizer教程】3DEqualizer4 R5新功能详解 【视频演示】

标签: 3DEqualizer

- 作者帖子

- 2019-08-19 - 17:39 #67163

追光参与者大家好,我是追光,许久没有更新追踪方面的技术贴,3DEqualizer的更新并不大,其主打服务仍然是3DEqualizer4 R5。这个版本做了较大幅度的升级,主要针对操作细节的优化,以及融入了人工智能图像追踪的算法。

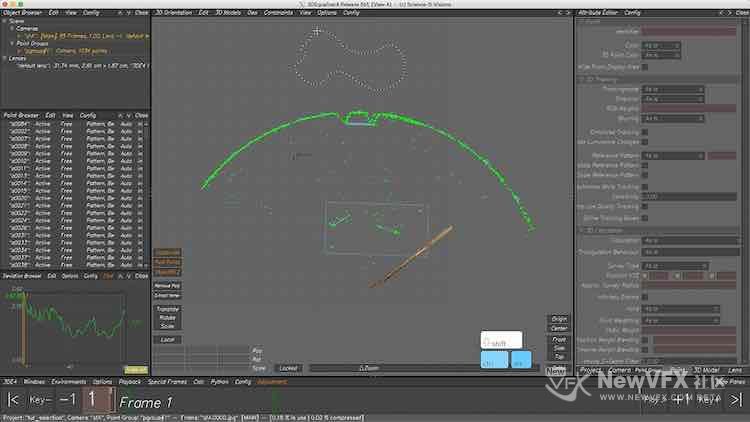

一、选择工具升级

3DE选择工具一直是方框选择,许多时候选择一个物体需要一点一点使用方框去圈选,非常耗时耗力。现在可以使用Berz曲线来快速选择三维空间、追踪曲线上的点,大幅度提升了效率。(快捷键 Crtl + Alt)

00:09

00:09二、可以存储自定义工作环境(界面)

根据屏幕的大小,可以从左下角Env(环境)选择任意一个操作界面,之后重新布置界面并存储为新的工作空间。

00:15

00:15三、一键快速隐藏非激活窗口(Hide Pones)

在工作时候,我们经常会在各种窗口之间快速切换,尤其是视图窗口与匹配窗口、三维窗口之间的切换非常频繁,用于检查我们的结果,3DE的操作窗口比较零碎,现在可以一键切换激活窗口为全屏幕显示啦,So Great~~(快捷键:TAB)

00:14

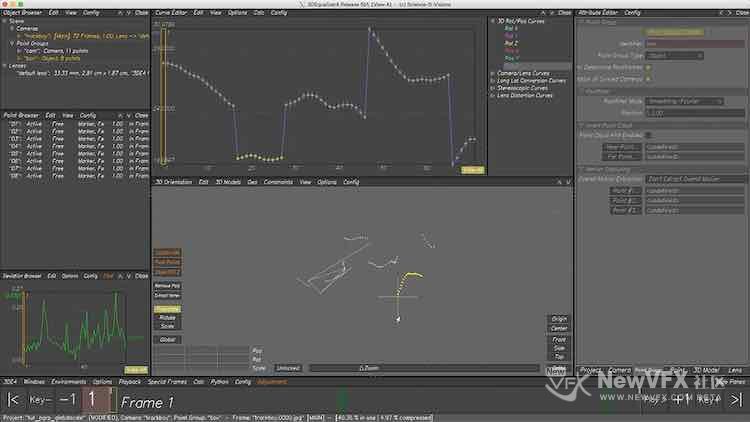

00:14四、动态点编辑器 (Dynamic Point)

在追踪的过程中,如果某一个点在某一段时间线上追踪不稳定,按照我们常规的做法是删掉整个点,而现在无需删除整个点,可以将不稳定的点转为动态(Dynamic)点,然后可以给这个点用berz 曲线绘制权重,不稳定的地方降低权重,稳定的地方增加权重。

00:31

00:31五、强制点进行解算(Force Point solve)

在带有较多运动模糊镜头反求追踪中,经常会出现点不解算的问题,这在之前是非常难进行解决的事情,只能手工逐帧追踪,费时费力且质量非常难以控制。现在不需要这样操作了,选择点—->>切换到属性编辑器—>>Trianglation Behavior(三角测量方式)–>>Force Point Solve(强制解算),即可将不参与计算的点参与到最终运算之中。

00:20

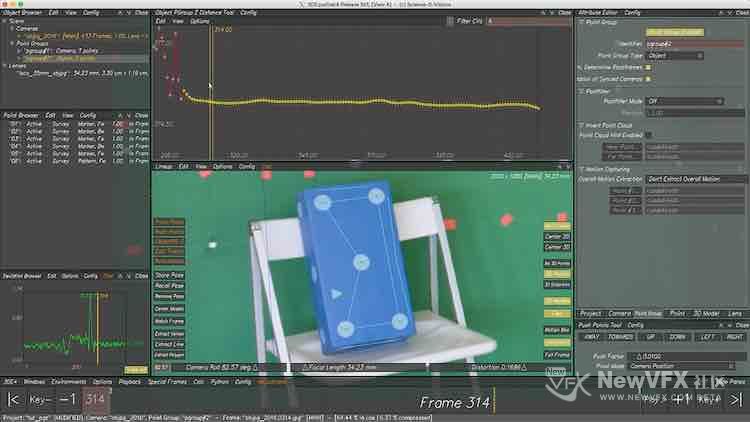

00:20六、几何体曲线编辑器

在追踪运动摄像机拍摄场景中的某个物体,对追踪出来的结果替换为三维物体进行匹配时,物体的大小与场景不匹配,轨迹有整体或局部上平行偏移,这通常是一件非常难以处理的事情。使用集合体编辑器,可以快速的平移某一帧或某一段时间的几何体坐标,效率得到巨大提升。

00:31

00:31七、点组“抖动”编辑(Z轴过滤修复)

有一种不算特别常见的极端情况,追踪完成后。实景与三维物体合成看起来非常完美,然而切换到三维视图的时候,三维点组却不停的在抖动,和帕金森症一致😄。细思恐极,这依然是非常棘手的问题。现在使用Config–>>Add Horizon Plane–>>Object Pgroup Z distance tool 中选择时间线上抖动的点组,设置Filter(过滤器)即可快速修复。

00:15

00:15八、VR影片追踪

将3DEqualizer优秀的追踪性能应用到了VR影片上,非常令人振奋,3DEqualizer最强的地方是追踪算法,其算法带来的高精度移植到VR影片,的确让人值得兴奋。另外还可以为VR拍摄支架上的相机进行重组,当支架受外部原因的影响,每个摄影机出现不同幅度抖动的时候,可以在整体支架范围内,对个别抖动的摄影机做重新绑定(对支架上的每个摄影机进行稳定并重新组合到一个良好的状态)。

00:17

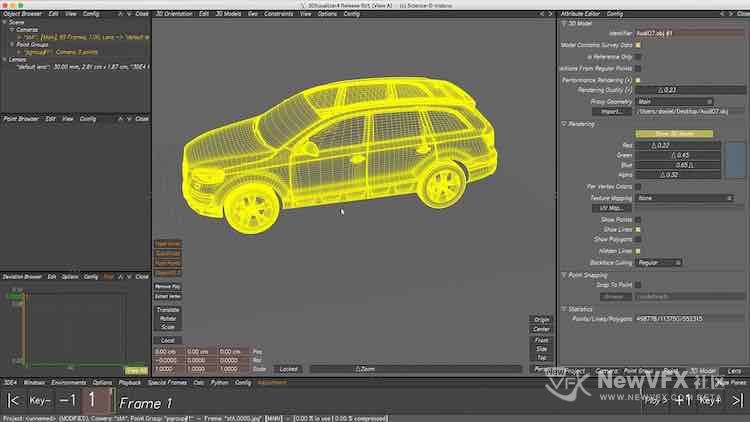

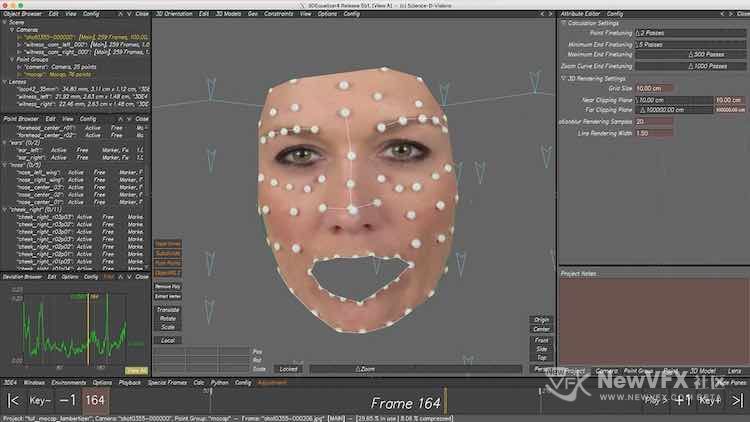

00:17九、3D渲染引擎优化

导入高精度模型时,对于配置低的机器渲染性能会很慢,而目前3D引擎支持通过拖拉的方式来切换渲染质量,从而提升渲染速度。

00:18

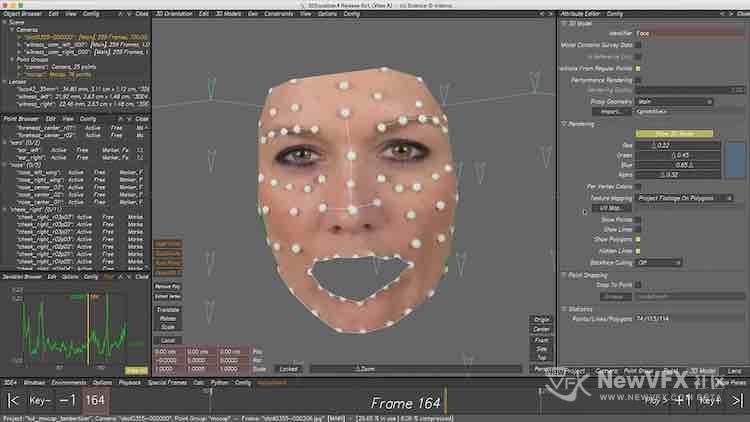

00:18十、支持uv贴图映射

在Mocap追踪或者几何体跟踪中,可以选择UV贴图快速查看跟踪效果。

00:11

00:11 00:11

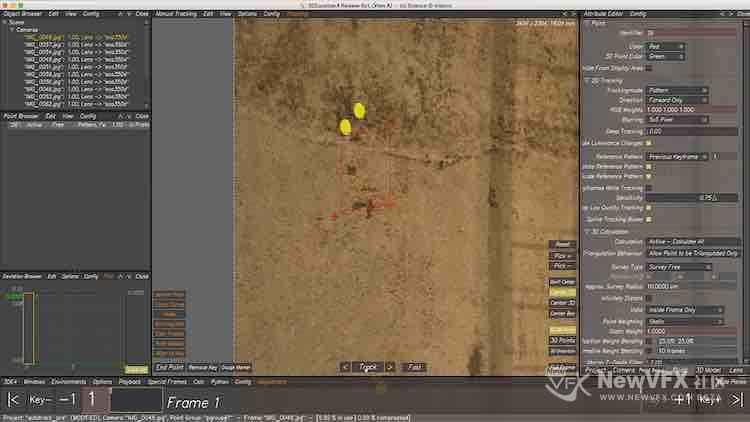

00:11十一、摄影测量自动追踪(本人最期待最期待的功能)

以前在做摄影测量的时候,导入参考帧后,每一个点都是往后一帧一帧的追踪的,假设拍摄了12张图片,每个点需要手工对位12次,20个点就需要对位240次,这可是手工追踪啊。且稍微不注意一点,整个参考帧点组就得全部重来。而现在3DE可以自动识别不通角度拍摄图片上的追踪点,Amazing,节省大量时间。😄

00:15

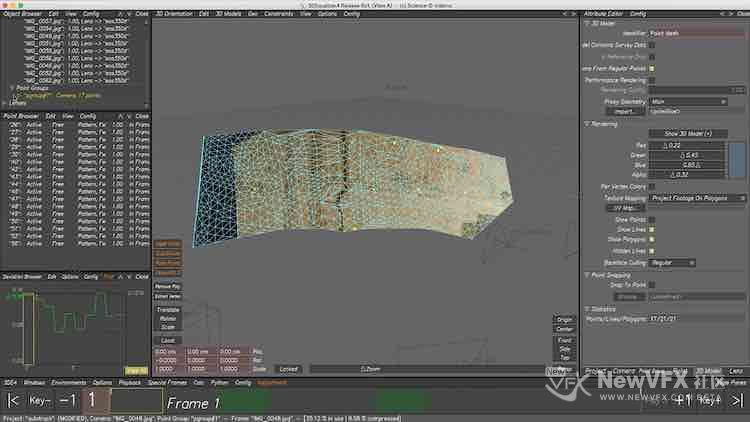

00:15十二、建模与贴图功能升级

现在可以在3DE中为反求出的物体快速进行建模并进行贴图,这样更方便3D后期制作人员进行模型拓补与重建。

00:14

00:14好啦,3DEqualizer4 r5的更新内容就写到这里了,不知不觉这篇帖子做了2天,可要用心学习哦。

另外,如有疑问,可以跟帖留言,追光会尽己所能,尽快回复大家的。

点击头像可以查看更多剪辑相关的教程,希望大家持续关注我哦,加我为好友,就可以看到我得更新啦,也可给我发私信,点击帖子顶部得收藏放入收藏夹,方便将来再次查看~,记得把帖子推荐给你的朋友哟~

本帖未经许可严禁转载,转载请注明出处并保留在本站的完整链接,且严禁二次转载,谢谢~

- 2022-10-25 - 15:02 #124896

冰花阳光下参与者3deR5用了一段时间后,打开界面就开始闪退打不开了,重新解压R5还是闪退,但是3deR4可以正常使用,这是什么情况

- 2025-09-16 - 14:32 #130761

never.&参与者配的图不见了 追光大佬

- 2025-09-16 - 14:53 #130762

追光参与者非常感谢提醒,看来这个问题存在一周了,最近一直在开发站点功能,把这个执行代码给禁用了,看到你的火速进行了修复。现在视频和图片都能正常播放、查看啦~~谢谢你🙏,有问题疑问也可以发上来,共同学习进步哇~~

- 2025-09-16 - 15:58 #130763

never.&参与者感谢大佬,有没有使用多张参考图片配合 反求运动物体的教程呀, 求出的物体空间不准

- 2025-09-16 - 16:10 #130764

never.&参与者还有个问题请教一下,如果没有畸变网格素材,但是在3de里面解算有做去畸变,这个数据可以导出到nuke吗 3de是有把去畸变的素材导出的这个知道 感谢

- 2025-09-16 - 17:45 #130766

追光参与者可以的,这个问题也曾经困扰过我很久。即便你手上没有拍摄的畸变网格(grid),只要你在 3DEqualizer 里做了去畸变(undistort)或已经解出镜头畸变参数,就有几种把结果带到 Nuke 的常用办法。

1.直接导出“已去畸变”的素材(Undistorted plate)+ 对应相机(undistorted camera),使用3DEqualizer的warp模块就可以导出。

2.从 3DE 导出 STMap(或 GridWarp)并在 Nuke 用 STMap 节点重建畸变/去畸变。(PFtrack官方的专用流程就是用这个)

思路:3DE 可以导出一个 STMap(通常是 EXR),把它在 Nuke 的 STMap 或 GridWarp 流程里接回去,就能对任意图像做 undistort 或 redistort(互逆)。通常要准备两个 EXR:一个用于 undistort,一个用于 redistort(或按导出说明)。3.直接将畸变计算好的数据传输到Nuke,使用 3DE 的 Lens Distortion Plugin Kit(LDPK)或导出到 Nuke 的 LensDistortion 节点 / GridWarp 脚本。

- 2025-09-17 - 13:38 #130770

never.&参与者感谢 大佬

- 2025-09-17 - 14:33 #130771

never.&参与者由于没有畸变网格,没有畸变数据的情况下, 在最后解算的时候 算出的畸变数据导出到nuke

我尝试了两种导出, Export Distortion to Nuke v7 Grid Warp…1.6 和Export Nuke LD_3DE4 Lens Distortion Nose v1.6 这两种节点和run warp4 导出的矫正的素材一样的 是第一种导出方式 Grid warp 所以想问一下,对于这种没有畸变网格素材的,导出畸变节点只能用Grid Warp 反之用第二种 - 2025-09-17 - 18:39 #130772

追光参与者畸变网格的主要作用是为了更加精确的畸变计算,没有畸变网格的情况3DEqualizer仍然可以按照画面进行计算或者手工绘制参数线段来实现更加精确的warp曲度计算。

也就是说,不管有没有畸变网格,畸变反求计算都是必备流程,因为这能大幅度提升提高计算的准确性。

然后最后就是导出到合成软件或者三维软件的问题:

三维软件比如houdini制作的画面都是没有畸变的,为了让其和物理镜头保持一致,我们会把计算3de计算出来的畸变渲染输出无畸变素材放到houdini当作预先合成背景参考:这样所有画面都是无畸变的。

在三维软件制作好渲染输出三维素材后,我们最终的合成是忠实于物理镜头的,将计算好的畸变数据添加到三维素材上+视频原始素材,最终所有画面都得到了和真实物理拍摄相机一致的畸变,更加真实。

因此畸变计算和传输是一一个过程,这三种方式都会用得到的。

- 2025-09-19 - 09:37 #130775

never.&参与者好的 感谢

- 作者帖子

- 在下方一键注册,登录后就可以回复啦。